En l'espace de 7 ans, l'art généré par IA a fait des bonds de géant. Nous ne créerons plus comme avant.

Vous avez toujours voulu créer des œuvres d’art, mais vous n’avez jamais été capable de dépasser le stade du bonhomme-dessiné-en-bâton ? Pas de souci, les générateurs d’art assistés par intelligence artificielle sont désormais disponibles (presque gratuitement) sur le web et permettent à n’importe qui de mettre en image des textes (pour le moment en anglais). Cette technologie basée sur le modèle CLIP de l’entreprise OpenAI a déjà donné naissance à un tout nouveau courant artistique qui a explosé depuis 2021. Mais l’histoire de l’art génératif ou art multimodal, remonte à quelques années et s'inscrit dans les évolutions de l’intelligence artificielle. Suivez le guide.

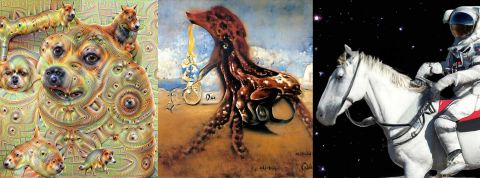

2015 : DeepDream

Vous vous souvenez de ces drôles d’images montrant un mélange de chiens et de visuels psychédéliques ? Il s’agissait des œuvres de DeepDream, un programme développé par l’ingénieur de chez Google Alexander Mordvintsev et basé sur un modèle de réseau de neurones appelé Inception (d’après le film du même nom). Au départ, le but était de détecter des objets dans des images pour les classer automatiquement. DeepDream faisait quant à lui le cheminement inverse. On lui donnait des images chargées de bruit aléatoire (le bruit est un terme désignant une bouillie de pixels indéfinie) et il s’efforçait d’y détecter puis d’afficher des objets qu’il avait appris à reconnaître. Étant donné que l’IA avait été nourrie avec la base de données ImageNet, remplie de photo d’animaux, elle finissait invariablement par générer des images avec des chiens ou des poissons dedans.

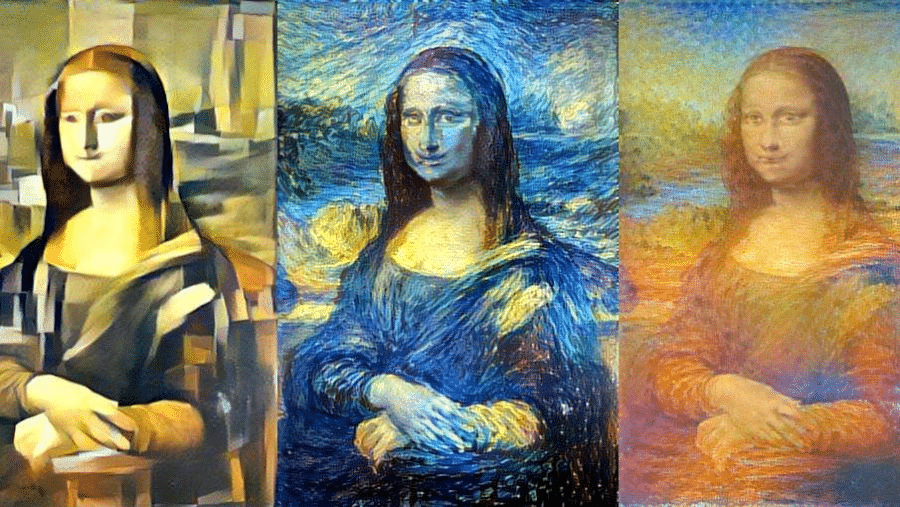

2016 : Style Transfer

Imaginé par des chercheurs de l’université de Cornell, Style Transfer est un algorithme qui peut reconnaître le « style » artistique, ou plus exactement les patterns d’un peintre ou d’un dessinateur. L’outil permettait surtout de reproduire des peintures connues dans un style différent, comme une Joconde en style cubiste.

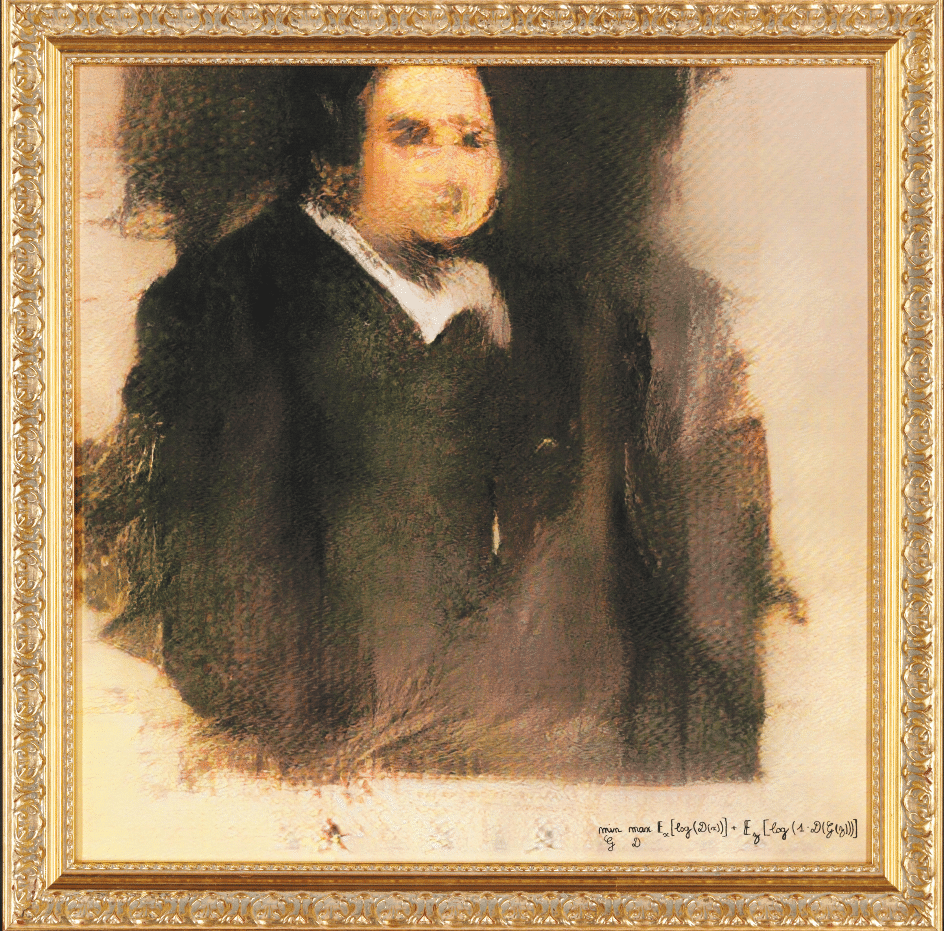

2018 : l’essor des GAN

En septembre 2018, les ingénieurs de Nvidia sortent StyleGAN, une IA basée sur un système de réseaux de neurones antagonistes (GAN en anglais). Concrètement, le système fonctionne sur deux réseaux qui s’opposent. Le premier est une sorte de critique qui possède dans sa base de données des milliers d’images d’un sujet en particulier (comme des visages par exemple). Le second prend le rôle de l’artiste et va créer un sujet qui doit répondre à certains critères pour être validé par le critique. Ce modèle a permis de générer des images de visages très réalistes, mais entièrement artificiels que vous pouvez consulter sur le site This person does not exist.

2021 : DALL·E et CLIP

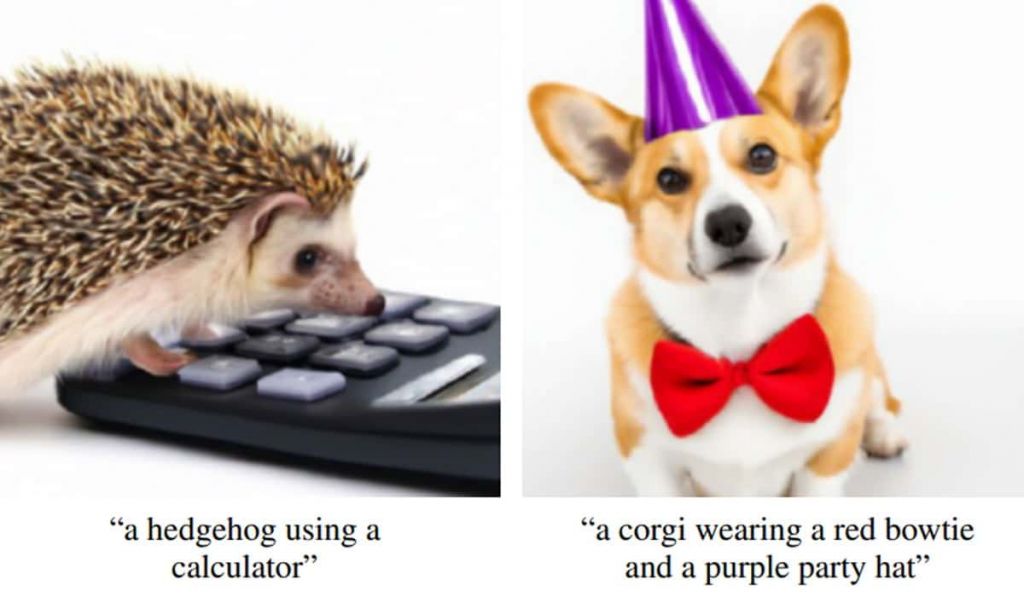

Ces deux modèles d’IA créés par OpenAI vont rebattre les cartes. CLIP est un modèle permettant de déterminer si le contenu d’un texte correspond à une image et si une image correspond au contenu d’un texte. Cet outil repose sur une base de données constituée de 400 millions de relations entre textes et images correspondantes. C’est aussi un élément présent dans le fonctionnement de DALL·E, une IA pouvant générer n’importe quel type d’image à partir d’un texte et basée sur le modèle de langage GPT-3. Sa force réside surtout dans la possibilité de mixer différents concepts ensemble. Il est ainsi possible de créer une chaise en forme d’avocat ou une mascotte de pingouin en salopette. Le code de DALL·E n’a jamais été partagé sous prétexte des implications éthiques apportées par cette technologie (certains pensent qu’il s’agit surtout d’un souci de droits étant donné que le modèle utilise des données issues du web pour fonctionner). En revanche CLIP est disponible en open source, ce qui a permis à une nouvelle génération d’artistes/codeurs de s’emparer de cette technologie.

Janvier 2021 : Big Sleep

13 jours après la sortie de CLIP, une première application pratique est diffusée sur le web. Il s’agit de Big Sleep, un outil créé par l’artiste Ryan Murdoch (Twitter @advadnoun) et mélangeant le modèle d’OpenAI à celui des GAN. Pour la première fois, n’importe quel internaute peut générer une image à partir d’un texte. Cet outil prend la forme d’un notebook, une interface un brin spartiate tournant sur la plateforme d’écriture et d’exécution de code Google Collab. Ce format, directement accessible depuis un navigateur web, permet de faire tourner ces générateurs gourmands en puissance de calcul sur les serveurs de la firme d’Alphabet, gratuitement ou bien contre un abonnement d’une dizaine d’euros. C’est sous cette forme que la plupart des générateurs ouverts à tous sont disponibles.

Mai-décembre 2021 : Guided Diffusion

Créé par un autre groupe de chercheurs travaillant chez OpenAI, Guided Diffusion est un nouveau modèle de génération d’images qui va être massivement utilisé pour créer les notebooks actuellement utilisés par les artistes. Son fonctionnement diffère totalement des GAN qui reposaient sur une opposition entre deux modèles d’IA. Guided Diffusion part lui aussi d’une image pleine de bruit puis diffuse peu à peu cette bouillie de pixels jusqu’à faire apparaître des formes dictées par un prompt. Le processus est plus lent, mais aussi bien plus précis, ce qui permet de générer des résultats plus précis et plus beaux. Quelques mois après sa sortie, l’artiste Katherine Crowson sort son notebook mélangeant CLIP et Guided Diffusion, qui va servir d’inspiration directe à OpenAI pour sortir sa propre version intitulée GLIDE.

2022 : Disco Diffusion, JAX, MidJourney et les autres

Une fois les bases posées, des communautés d’artistes codeurs vont s’emparer de ces outils (pour la plupart open source) pour créer les notebooks les plus connus comme Disco Diffusion ou MidJourney (encore en accès bêta). S’ils sont tous basés sur les mêmes modèles d’IA, ces derniers sont améliorés avec une étape appelée fine tuning qui permet de leur ajouter une couche d’entraînement supplémentaire. Résultat : les artistes ont le choix entre différents générateurs en fonction du type d’image qu’ils veulent créer.

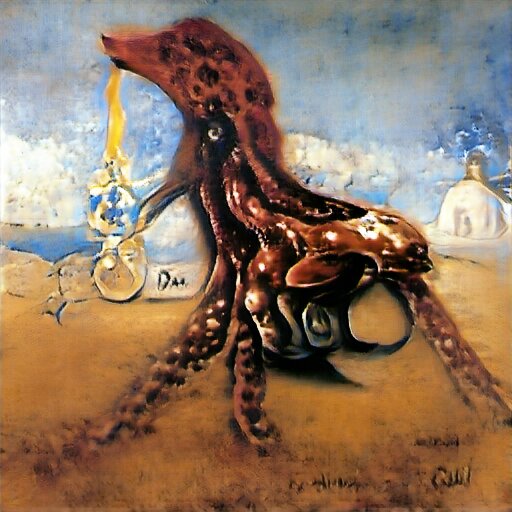

Avril 2022 : DALL·E 2

Après avoir révolutionné la génération d’images en 2021, OpenAI revient sur le devant de la scène avec DALL·E 2, une nouvelle version encore plus puissante et précise. L’outil, non disponible publiquement, peut prendre une image initiale et la recréer très fidèlement dans un angle différent ou bien jouer de manière très fine sur les textures afin de donner un aspect pâte à modeler ou fil de laine à une création. Enfin, il améliore encore plus le mélange de différents éléments, permettant de créer des concepts graphiques complexes comme cet astronaute montant un cheval. Pas étonnant qu’il fasse un peu peur !

Participer à la conversation