Capable de reconnaître des visages, des voix, des animaux ou même des émotions, l’IA paraîtrait presque infaillible. Mais des spécialistes rappellent un principe : tout est piratable.

Les assistants vocaux tels que Siri, l’assistant Google ou encore les enceintes connectées utilisent déjà ces technologies. Demain, elles intègreront les voitures autonomes. L’intelligence artificielle est aujourd’hui une sorte d’interface entre l’humain et le monde « réel ». Une fonction appelée à se développer.

Avec la généralisation de l'IA, les conséquences de ses échecs vont aller crescendo : si Siri se trompe de mot dans l’un de vos textos, rien de grave ; si une voiture autonome décide d’accélérer devant un dos d’âne en plein quartier résidentiel, les conséquences pourraient être dramatiques.

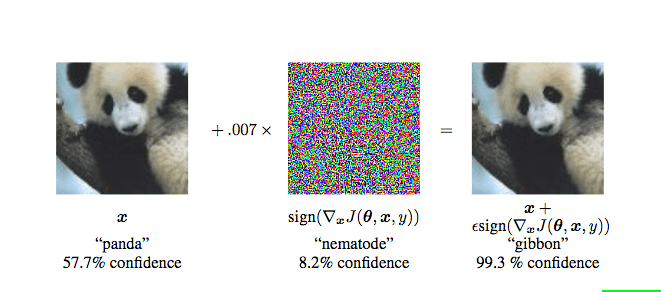

Tromper l’IA, c’est justement l’objectif des attaques dites « adversarial » (par antagonisme, contradiction). Les hackers utilisent ce qui serait, pour les humains, des illusions d’optique. Les attaques modifient (faiblement) les données soumises à l’intelligence artificielle pour la flouer et fausser le résultat qu'elle produit.

Des chercheurs de Google ont démontré l’impact que pourraient avoir ces modifications en les illustrant. Au départ, l’IA serait capable ici de reconnaitre un panda, après un léger remaniement, elle identifierait un singe gibon…

Illustration issue de l’étude Robust Physical-World Attacks on Deep Learning Models

Participer à la conversation