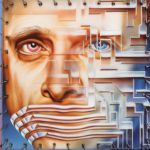

Ilya Sutskever, co-créateur de ChatGPT, est persuadé que les ingénieurs qui participent à la création de l’Intelligence Artificielle Générale courent de grands dangers.

« Nous allons certainement construire un bunker avant de lancer l'IAG. » C’est par cette petite phrase, légèrement inquiétante, qu’Ilya Sutskever, cofondateur et directeur scientifique d'OpenAI, a commencé sa réunion avec un groupe de ses nouveaux chercheurs durant l’été 2023. Alors qu’il travaille sur l’amélioration du modèle de langage d’OpenAI, cet informaticien est obsédé à l’idée de créer une intelligence artificielle générale (AGI), c’est-à-dire une IA capable d’effectuer et d’apprendre n’importe quelle tâche cognitive au moins aussi bien qu’un humain. Fantasmé par les chercheurs depuis les années 50, ce concept d’IA n’existe pas encore et pourrait ne jamais voir le jour. Mais Sutskever est persuadé que son avènement est imminent et il a passé beaucoup de temps à imaginer les conséquences d’une telle invention.

Tous dans le bunker

Dans le livre à paraître Empire of AI, dont les bonnes feuilles sont lisibles sur The Atlantic, la journaliste Karen Hao raconte qu’Ilya Sutskever évoquait fréquemment les scénarios catastrophiques qui pourraient devenir réels avec l’arrivée de l’IAG. Ce dernier était ainsi persuadé que cette technologie est tellement convoitée que la plupart des chercheurs ayant travaillé dessus devraient se réfugier dans un bunker afin d’éviter d’être enlevés par des gouvernements rivaux ou ennemis. D’autres témoins évoquent aussi la fameuse apocalypse IA qui revient très souvent dans les cercles rationalistes fréquentés par Sam Altman ou Elon Musk. Beaucoup sont adeptes d’un exercice de pensée intitulé Basilic de Roko (du pseudo de son inventeur) selon lequel une intelligence artificielle du futur pourrait choisir de punir ceux qui, dans le passé, ont eu connaissance de son potentiel d'existence mais n'ont pas activement contribué à sa création. Dans le cadre de cette possible apocalypse où l’IA prendrait le contrôle sur tous les aspects de notre vie (ces gens ne prévoient-ils pas de boutons off ? ), Ilya Sutskever aurait même évoqué l’idée d’un ravissement (rapture en anglais) très proche de ce qu’imaginent les évangélistes.

Le coup d'État raté

Bien qu’il n’ait jamais été question d’obliger les scientifiques à descendre dans un bunker ( « cette option est facultative bien sûr », précisait Sutskever), le cofondateur d’OpenAI était toutefois très préoccupé par les éléments de sécurité entourant le déploiement des intelligences artificielles. Ce dernier jugeait d’ailleurs Sam Altman beaucoup trop léger sur ces questions, notamment après que ce dernier ait cherché à contourner les processus de sécurité mis en place par le Deployment Safety Board (DSB) de l'entreprise pour le modèle GPT-4 Turbo.

Pour le contrer, Sutskever et l’ingénieure Mira Murati ont tenté un coup d’État à la fin de l’année 2023 afin de l’évincer de l’entreprise. « Je ne pense pas que Sam soit le gars qui devrait avoir le doigt sur le bouton pour l'IAG », a déclaré Sutskever, selon les notes dévoilées par Hao. Bien que le conseil d’administration ait révoqué Altman, la décision fut de courte durée. Sous la pression des investisseurs, des employés et de Microsoft, ce sont Sutskever et Murati qui ont finalement été évincés – Sam Altman ayant pu reprendre les rênes. Depuis, il s’est éloigné des discours catastrophistes et prédit même une « ère de l'intelligence », caractérisée par une « prospérité massive ». On lui souhaite d'avoir raison – pour nous tous.

Participer à la conversation