Depuis 2023, un mème circule dans le milieu de l’industrie de l’IA, comparant les IA à des monstruosités tentaculaires issues du bestiaire d’H. P. Lovecraft.

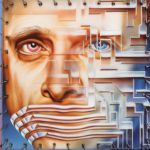

Imaginez une masse de chair gélatineuse et tentaculaire, perpétuellement en mouvement, qui considère les humains de la même manière que nous considérons les fourmis. Cette monstruosité issue de la nouvelle Les Montagnes hallucinées de H. P. Lovecraft, et qui porte le nom de shoggoth, est devenue, en l’espace de quelques années, une blague cryptique du monde de l’IA lorsqu’il s’agit d’évoquer le fonctionnement des chatbots. Présenté sous la forme d’un amas de tentacules tenant un petit smiley, qui se décline en dessins, peluches ou autocollants pour voiture, ce mème a longtemps circulé dans le milieu rationaliste et techno-enthousiaste, comme celui de Dime Square.

Du « puppyslug » au « shoggoth »

Dans un article consacré à cette blague, le New York Times fait remonter son origine à un post Twitter/X du 31 décembre 2022, un mois après la sortie officielle de GPT-3. Publié par le compte Tetraspace, le dessin montre deux versions du chatbot d’OpenAI. Le premier est représenté sous la forme du shoggoth, tandis que le second, intitulé « GPT-3 + RLHF », montre la même créature affublée du fameux smiley souriant. L’idée est d’expliquer que ces modèles de langage avaient tendance à fournir des réponses étranges et inquiétantes avant que l’on n’ajoute à leur système un « apprentissage par renforcement à partir de retours humains » (reinforcement learning by human feedback, RLHF). Pour la petite histoire, cette méthode d’apprentissage, qui consiste à comparer différentes réponses produites par les chatbots et à récompenser les plus pertinentes ou les plus polies, repose sur des « travailleurs de la donnée » invisibilisés et bien souvent exploités dans des pays en voie de développement.

Si cette blague semble faire l’unanimité au sein de la communauté IA, c’est en premier lieu parce que la représentation des grands modèles de langage en monstres lovecraftiens remonte en réalité à 2015. Comme l’expliquent Valentin Goujon et Donato Ricci dans leur article « Shoggoth with Smiley Face : faire-savoir et savoir-faire par l’analogie au sein de la recherche en intelligence artificielle », l’analogie est véritablement née avec la sortie de DeepDream, l’outil de visualisation de réseaux de neurones profonds qui générait des images psychédéliques de chimères animales. Sur des réseaux comme Reddit, ces morphings de chiens présentant plusieurs yeux et plusieurs bouches sont alors évoqués sous les termes de « puppyslug » ou de « shoggoth ».

Cette comparaison va ensuite glisser vers les LLM, et notamment vers le modèle GPT-3 + RLHF, qui marque, au sein de l’industrie, la capacité à brider les agents conversationnels et à empêcher les utilisateurs de les faire dérailler via un jailbreak.

Qui est vraiment le shoggoth ?

Dans la même période, un billet de blog de l’influent psychiatre états-unien Scott Alexander Siskind vient fixer définitivement cette image de monstruosité. Dans son article intitulé « Janus’ Simulators », il tente de repenser la catégorisation de l’intelligence artificielle afin de se détacher des vieux concepts hérités des années 2000 qui comparaient ces systèmes à un agent poursuivant des objectifs, à un oracle fournissant des réponses ou à un génie exécutant des demandes. Pour Siskind, ces images sont trompeuses et ne représentent pas réellement le fonctionnement des LLM, fondé sur des prédictions statistiques sans intention propre, sans cohérence interne stable ni finalité autonome. Ces modèles de langage, qui ne veulent ni ne décident rien, sont surtout caractérisés par leur capacité à simuler des personnages, des voix, des raisonnements ou des styles d’écriture. Ce producteur de simulacres au fonctionnement opaque et largement incompréhensible pour l’humain correspond parfaitement au monstre de Lovecraft : une entité amorphe, malléable, capable d’adopter des formes multiples, difficilement contrôlable et fondamentalement étrangère à l’humanité.

L’analogie de Scott Alexander va s’avérer particulièrement efficace et populaire, car, en plus de souligner l’altérité de cette nouvelle génération de machines, l’idée du monstre équipé d’un masque souriant permet aussi de pointer du doigt les comportements humains. À la manière des GPT-3 + RLHF, nous serions nous aussi des « machines de prédiction affinées par du renforcement ». Notre comportement social est lui-même modelé par notre éducation, que l’on pourrait résumer à des mécanismes analogues de récompense, de sanction et d’ajustement. Ce brouillage des pistes, plutôt malin, entre l’humain et l’IA explique sans doute pourquoi la figure du shoggoth au visage sympathique est devenue mainstream en 2026, dans l’Amérique de Trump.

Participer à la conversation